在7月29日的Unity技术开放日(上海站)活动里,Unity向开发者展示了最新的数字人Demo,分享了基于Unity的完整制作流程。由上海科技大学MARS实验室打造的穹顶光场扫描技术也在活动中首次亮相。

(来源:Unity技术开放日)

从影视特效到游戏再到现在的MetaVerse元宇宙概念,人们对数字人技术的追求从未停止过。随着计算机图形学、计算影像学以及一系列专业制作工具的不断发展,数字人也从电影特效里对数字替身的高精度离线渲染走向实时。

在这个系列里,我们将从扫描、制作、驱动、渲染等多个方向出发,介绍数字人技术的演进。接下来,作为这个系列的第一篇,我们将从“扫描”开始带大家进入数字人的世界……

P.S. 脸作为人最重要的部位,我们所有的介绍都默认以脸为对象来展开。

01 “传统”方案

在CGI(Computer-generated imagery)还没有那么发达、还不需要对角色进行数字化处理的时候,艺术家们如何完成对演员的建模的?答案是活体铸模(Life Casting)技术——这绝对是你能想到最传统的“扫描”方案了。

活体铸模是通过使用成型和铸造技术,创造一个活体的三维副本的过程。铸模通常只限于身体的一个部分,但全身的铸模也是可以实现的。铸模可以复制小到指纹和个别毛孔的细节。

但整个铸模过程对演员就没那么友好了。特效化妆师会将蓝色绿色的矽胶涂满演员脸以得到阴模,整个过程中演员要尽可能保持静止;而后在阴模中敷入石膏等材料,得到原始的活体阳模,再进行后续的加工处理。放一张图让大家体会一下……

(来源:Youtube Insider频道)

活体铸模虽然是一种传统的建模方案,在人脸重建方面早有更高级的影像学方法(也是我们后面会介绍的内容)能达到出色的效果,但活体铸模技术依然被沿用至今,在一些特效化妆或是身体部位的建模中活体铸模技术依然是首选,比如大家也许比较熟悉的强尼银手的手……

(来源:Youtube Insider频道)

02 结构光

2017年9月在Apple Park的Steve Jobs剧院,搭载了Face ID的iPhone X横空出世,从此结构光这个词开始进入大众的视野,手机也正式进入了深度传感器时代。

(发布会上介绍iPhoneX的FaceID功能)

结构光是通过激光器,将具有一定结构特征的光线投射到被拍摄物体上,再由摄像头进行采集反射的结构光图案进行深度信息的计算。依据采用结构图案的不同,可以分为线扫描结构光和面阵结构光等等。

iPhoneX上的Truedepth相机使用了以色列PrimeSense公司的Light Coding技术。该方案通过投射人眼不可见的伪随机散斑红外光点到物体上,每个伪随机散斑光点和它周围一定范围内的点集在空间分布中的每个位置都是唯一的,并将预先进行了存储,是典型的面阵结构光。

(iPhoneX结构光在红外相机下的样子)

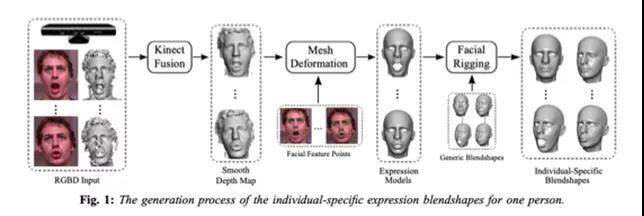

曾被称为“黑科技”的XBox Kinect(初代)体感摄像头使用的也是这一套方案。值得一提的是,浙江大学周昆教授的3D人脸数据集Facewarehouse就是使用Kinect采集的。

(Kinect水果忍者游戏,记忆里的黑科技)

(Facewarehouse数据集)

面阵结构光也能使用在全身模型的扫描上,并利用其扫描帧率上的优势实现动态人体模型的扫描。Google在2018年发表的The relightables: volumetric performance capture ofhumans with realistic relighting对人体的几何扫描使用的就是面阵结构光。

(Google的LED Egg使用的结构光)

为了得到更高精度的人脸模型,研究人员往往会采用线扫描结构光的扫描手段。常见的方法是使用一台投影仪,向演员面部周期性投影不等宽的线形竖直条纹,再根据条纹在演员面部发生的形变去推断演员的几何。这种方案往往比面阵结构光需要更长的扫描时间,也能达到更高精度的扫描结果。并且只需要投影仪与一台相机,硬件相比接下来的相机阵列法和光度立体法成本也更低,是一种比较经济的扫描方案。

(基于线扫描结构光的人脸扫描)

03 摄影制图法

今年3月,Epic忽然在官网宣布完成对Capturing Reality的收购。后者是一家摄影制图技术公司(Photogrammetry),该公司开发的Reality Capture软件能够允许开发者通过无序的照片或激光扫描来创建高质量的3D模型。简单来说,你只要拿手机对着物体拍一圈,就能完成对该物体的3D扫描。

(来源:Epic官网)

同类的软件还有AgisoftPhotoscan、AutodeskReCap、VisualSFM,以及开源的OpenMVS等等。在拿LiDAR测了几年距之后,Apple也终于在今年的WWDC2021推出了Object Capture实现类似的功能,联合起AR Kit算是一套不错的组合拳了。

(来源:Apple WWDC 2021)

回到数字人扫描的话题中来。摄影制图法应该是行业内用于人脸建模的最主流方案了,它既可以只用一台相机完成质量还OK的模型扫描,又可以花大价钱组相机阵列光源阵列来实现高精度的扫描。

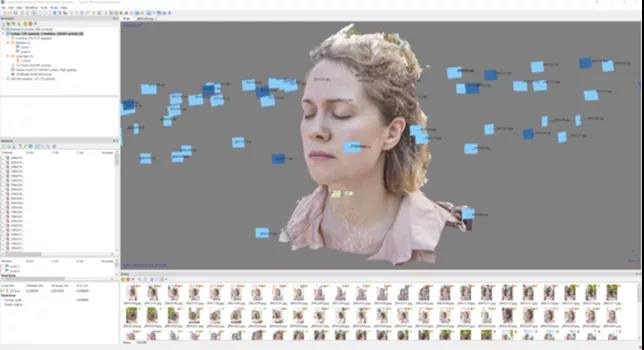

(使用单相机与Agisoft完成的人脸建模)

摄影制图法的底层原理是利用图片间的相同特征点来进行配准,而后使用MVS、SFM等方法进行重建。照片的分辨率、相机内外参的标定、人脸光线的均匀程度、演员的移动等等因素都会影响最终的重建质量,而且在影视级的扫描中,往往还会有消除高光等需求。这就需要一个相对理想的拍摄环境来很好的控制以上的因素,一大批扫描技术提供商应运而生,国内做的比较好的有PixelLight、诺华视创等等,都承接了许多影视业务。

(PixelLight的球阵扫描系统)

(诺华视创的球阵扫描系统)

可能有人会注意到上面图中的相机扫描阵列与接下来将讲到的Light Stage很像,但由于软件算法的缺失,市面上大部分球形扫描系统使用的依然是上文提到的几款摄影制图软件,采用球阵目的还是为了控制相对光照均匀、增加偏振以及对方便对相机进行预标定,在精度上依然无法与接下里要介绍的光度立体法对皮肤表面Normal直接扫描得到的模型相匹敌。但随着Reality Capture等一票软件的不断升级,现在也勉强能够达到接近毛孔级别的细节。

(腾讯SIREN项目中的扫描)

(PixelLight提供的高精度扫描)

近两年得益于高速相机硬件的提升,4D扫描的成本降低了很多,PixelLight等公司已经着手研发基于摄影制图法的面部4D扫描系统。腾讯NextStudio的SIREN项目与Unity的Heretic项目中也都已经引入了4D扫描数据作为艺术家的参考,相信4D扫描数据的应用接下来也将会成为行业的一个研究趋势。

(帅气的京一老师自己的4D扫描数据)

04 光度立体法

2019年初,Paul Debvec获得了Oscar SciTech Award奖项。你可能不知道这个大胡子有点微胖的人是谁,但你一定知道他作为主要贡献者的HDR技术。

(PaulDebvec获奥斯卡SciTechAward)

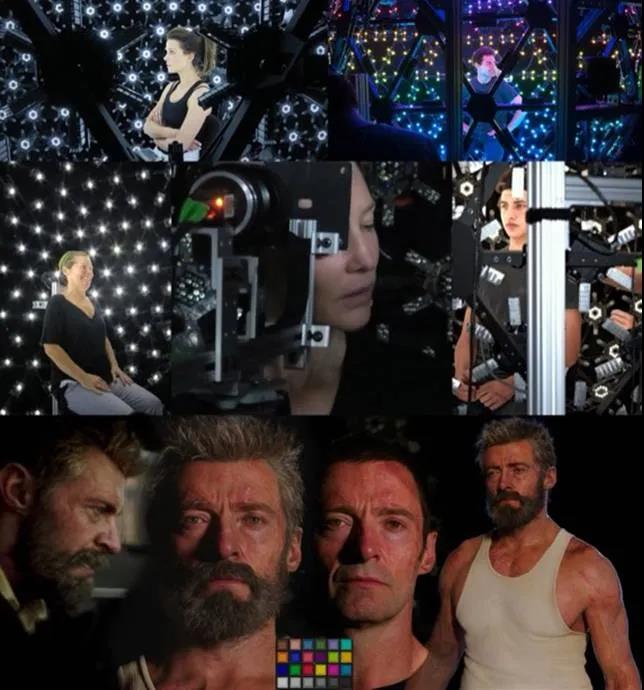

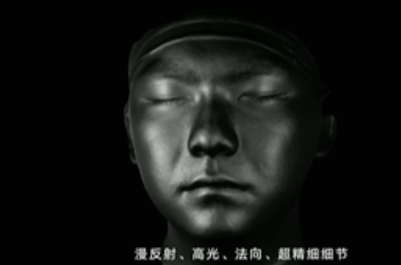

当然,这次获得奥斯卡技术成就奖并不是因为HDR,而是LightStage扫描技术。LightStage是由美国南加州大学ICTGraphic Lab的PaulDebevec所领导开发的一个高保真的三维采集重建平台系统。该系统以高逼真度的3D人脸重建为主,并已经成功应用于40多部好莱坞电影渲染中。从第一代系统Light Stage 1至今已经升级到Light Stage 6,最新的一代系统命名为Light Stage X。

(USC ICT拍摄的众多巨星)

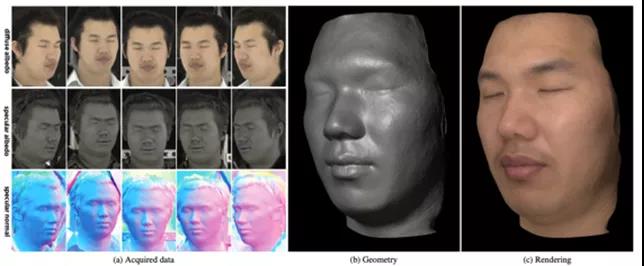

Light Stage本质上是一套光源、相机协同采集系统,能够对每个光源进行独立编程控制其亮度和颜色,在Light Stage内模拟出较为理想的各种光照环境。Light Stage使用光度立体法来完成对演员面部Normal的直接扫描,能够达到摄影制图法无法超越的细节程度。具体来说,Light Stage利用其可编程光源打出符合某种梯度分布的多种光源,并以此采集到的图像来计算演员表面的PBR材质。具体的原理可以在ICT VGL官网放出的Paper中找到,知乎用户春日也做了不错的总结。

(基于梯度光的光度立体法)

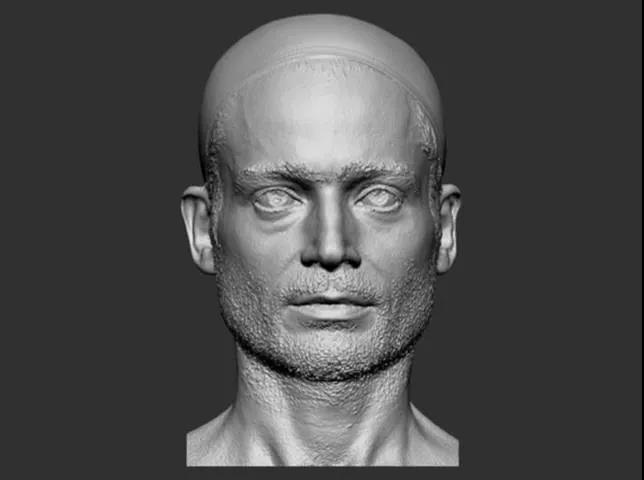

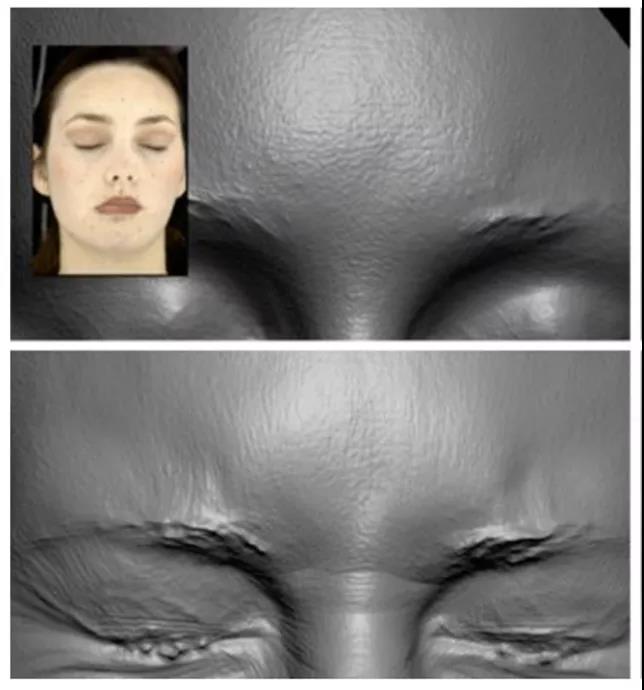

严格上来说,光度立体法并不提供准确的几何结构,Light Stage中依然使用摄影制图或结构光的方法来获取演员的准确几何,再使用光度立体法获得的法向来对模型表面进行高精度细节的计算——加入光度立体法其实是叠buff。也正是如此,LightStage扫描技术能够超越上述几种方法受到更多好莱坞大片的青睐。

(USC ICT的Digital Emily项目的精度)

可能会有人说Normal通过高低模烘焙的手段也可以得到,但其实这样得到的Normal本质上也还是几何,无论是精度还是表现上都与扫描得到的Normal差异巨大。烘焙出来的Normal精度受制于几何,往往比较有棱有角、像浮雕,而扫描得到的Normal是像素级别的,表现上也更加圆润、更自然。

(左:烘焙法向;右:扫描法向)

然而,Light Stage搭建困难、运输不便、成本高,基于光度立体法的Normal推算也没有成熟的商业解决方案,很多算法上的know-how无从知晓,致使国内长期以来一直没有这种级别的扫描技术出现。超维的VR3D也使用了光度立体法作为扫描手段,但距离Light Stage级别的扫描还有一定距离。

(超维的VR3D扫描结果)

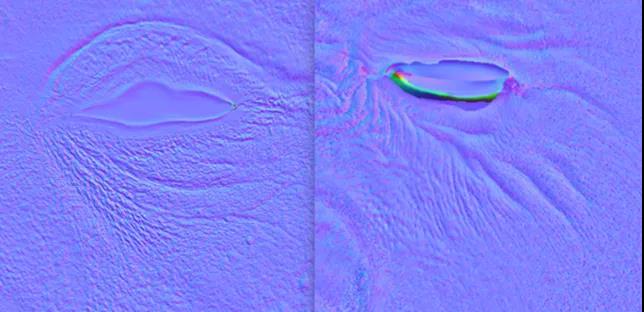

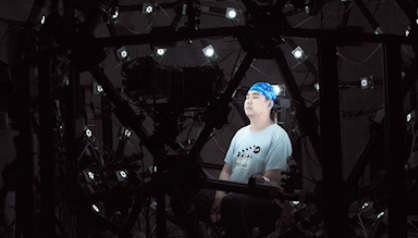

这次在Unity技术开放日中亮相的上海科技大学MARS实验室(也就是笔者所在的实验室)的穹顶光场(Light Field Stage),包含约150个256级可控LED光源,每个LED光源带有6个高亮度LED灯珠,这些灯珠分为两组独立控制,两组分别安装有不同的偏振片。光源均匀分布于一个直径约3米的铝合金框架球体上。所有灯光以最高1000Hz的频率变化亮度,并与三台高速相机、三十台工业相机实现毫秒级同步,所有的灯光每变化一次亮度的同时,高速相机进行一次拍摄——要达到这种级别的同步性,连通信协议都是需要自己研发定义的。

(穹顶光场数据采集)

在无数次算法迭代后,目前MARS实验室的穹顶光场已经能够输出4D高精度几何与PBR材质,扫描精度能够达到皮肤毛孔级别,向影视需求提供千万面级高模,对游戏行业也提供低模+Normal的解决方案,欢迎一起来合作测试。相信未来会在行业里更多的看到我们的身影…

(穹顶光场模型精度)

(穹顶光场Normal细节)

05 未来

身处行业之中,你很难不听到Metaverse这个词,但每个人都对这个词都有不同的理解——一个基本的共识是,数字人必然是Metaverse的入口。如何低成本的生成真是的数字人是一个亟待解决的问题。

Epic在今年推出的MetaHuman无疑是惊艳的,单归根结底始终只是一个高级的通用捏脸系统,无法实现对数字人脱离框架的“创造”。

(来源:Epic Metahuman)

在2D人像生成的问题上,NVIDIA与2019年底提出的StyleGAN2已经达到了逼真到难以分辨的细节,甚至上传任意一张人像StyleGAN都能在它的隐式空间中找到“那个世界里的”替身,更是衍生出了一系列编辑年龄、性别、长相等其他应用。

(在StyleGAN中寻找马克龙)

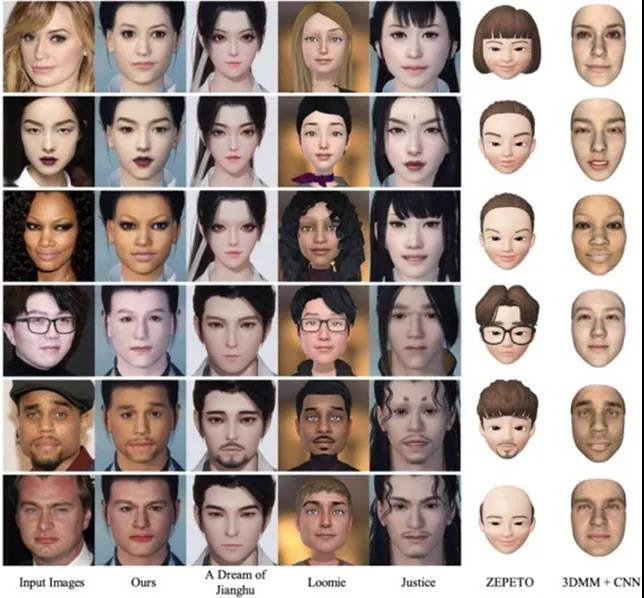

笔者认为真正的MetaVerse应该共用一套覆盖面足够广泛的数字人角色系统,每个人的形象在系统中仅仅是以其真实长相为基础的一个独一无二的latent vector(当然可以根据自己的想法整个容),不同的平台再根据自己的需要在同个隐式空间内对形象进行统一的风格化迁移调整——这个过程就像之前很火的Toonify一样。

(Toonify在StyleGAN空间的基础上对每张脸进行风格化)

MetaVerse时代单用户获取自己数字形象的成本应该是要相当低的,所谓“扫描”应该要缩减至仅需若干张照片或粗糙的三维模型仅可完成,数字形象应该由一个具有足够表达性能的网络来生成后用户再微调,而不是让用户花大把时间在有限组合的捏脸系统里捏脸,换个游戏后又要重新捏。

光有生成还不够,要想组成一个“Verse”,统一的形象管理是相当必要的。互联网时代国外相当多的平台都接入了GRAVATAR来允许用户进行统一的头像管理,MetaVerse时代也需要有这样一个平台来保存每个用户的基础形象,再开放给不同的平台来按需风格化……

(各种游戏/软件的照片捏脸效果比较)

学术圈也是有往这个方向做的趋势的。上个部分提到的南加州大学ICT实验室在2020年发表的一项成果里,引入了一个全面的框架,从高精度面部扫描数据中学习基于物理的人脸模型,利用深度学习的3D可变形人脸建模方法抓住了近4000个高精度人脸扫描的特征,包括表情和身份分离等等,颇有一种3D StyleGAN的感觉。

(来源:USC ICT VGL)

利用穹顶光场这样的高精度面部扫描设备,上海科技大学MARS实验室也正在进行高精度多表情含PBR材质人脸模型方面数据储备,在人脸生成问题上发表了SofGAN等高质量工作,在建模与渲染问题上也提出了多种基于Neural Rendering的方案。敬请期待我们未来的工作。

版权声明 | 文章配图仅供学习参考,引用图片版权归属原作所有

如有问题,请及时与我们联系,我们将第一时间做出处理

作者:无私向斑马

2023-10-25 04:00:03

作者:无私向斑马

2023-10-25 04:00:03

Android版下载

Android版下载